En este tutorial, le mostraremos cómo instalar Apache Spark en el servidor CentOS 7. Para aquellos de ustedes que no lo sabían, Apache Spark es un sistema informático de clúster rápido y de propósito general. Proporciona API de alto nivel en Java, Scala y Python, y también un motor optimizado que admite gráficos de ejecución generales. También admite un amplio conjunto de herramientas de alto nivel que incluyen Spark SQL para SQL y procesamiento de información estructurada, MLlib para máquina aprendizaje, GraphX para el procesamiento de gráficos y Spark Streaming.

Este artículo asume que tiene al menos conocimientos básicos de Linux, sabe cómo usar el shell y, lo que es más importante, aloja su sitio en su propio VPS. La instalación es bastante simple y asume que se están ejecutando en la cuenta raíz, si no, es posible que deba agregar 'sudo ' a los comandos para obtener privilegios de root. Le mostraré la instalación paso a paso de Apache Spark en el servidor CentOS 7.

Instalar Apache Spark en CentOS 7

Paso 1. Primero, comencemos asegurándonos de que su sistema esté actualizado.

yum clean all yum -y install epel-release yum -y update

Paso 2. Instalación de Java.

Instalando java para el requisito de instalar apache-spark:

yum install java -y

Una vez instalado, verifique la versión de Java:

java -version

Paso 3. Instalación de Scala.

Spark instala Scala durante el proceso de instalación, por lo que solo debemos asegurarnos de que Java y Python estén presentes:

wget http://www.scala-lang.org/files/archive/scala-2.10.1.tgz tar xvf scala-2.10.1.tgz sudo mv scala-2.10.1 /usr/lib sudo ln -s /usr/lib/scala-2.10.1 /usr/lib/scala export PATH=$PATH:/usr/lib/scala/bin

Una vez instalado, verifique la versión de Scala:

scala -version

Paso 4. Instalación de Apache Spark.

Instala Apache Spark usando el siguiente comando:

wget http://www-eu.apache.org/dist/spark/spark-2.2.1/spark-2.2.1-bin-hadoop2.7.tgz tar -xzf spark-2.2.1-bin-hadoop2.7.tgz export SPARK_HOME=$HOME/spark-2.2.1-bin-hadoop2.7 export PATH=$PATH:$SPARK_HOME/bin

Configure algunas variables de entorno antes de iniciar Spark:

echo 'export PATH=$PATH:/usr/lib/scala/bin' >> .bash_profile echo 'export SPARK_HOME=$HOME/spark-2.2.1-bin-hadoop2.6' >> .bash_profile echo 'export PATH=$PATH:$SPARK_HOME/bin' >> .bash_profile

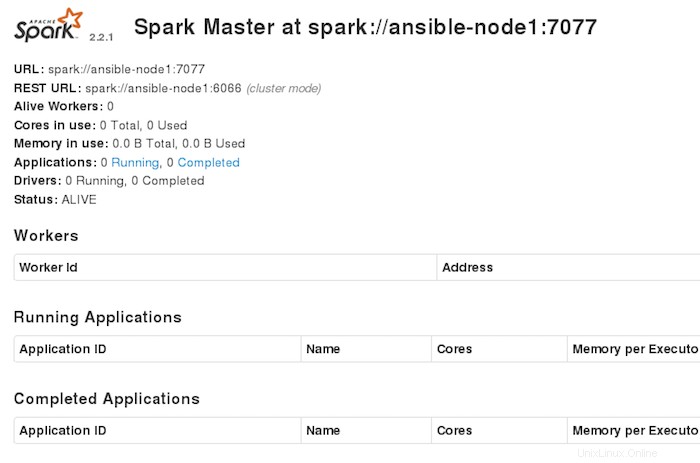

El clúster de Spark independiente se puede iniciar manualmente, es decir, ejecutar el script de inicio en cada nodo o simplemente usar los scripts de inicio disponibles. Para realizar pruebas, podemos ejecutar demonios maestros y esclavos en la misma máquina:

./sbin/start-master.sh

Paso 5. Configure el cortafuegos para Apache Spark.

firewall-cmd --permanent --zone=public --add-port=6066/tcp firewall-cmd --permanent --zone=public --add-port=7077/tcp firewall-cmd --permanent --zone=public --add-port=8080-8081/tcp firewall-cmd --reload

Paso 6. Acceso a Apache Spark.

Apache Spark estará disponible en el puerto HTTP 7077 de manera predeterminada. Abra su navegador favorito y vaya a http://yourdomain.com:7077 o http://your-server-ip:7077 y complete los pasos necesarios para finalizar la instalación.

¡Felicitaciones! Ha instalado con éxito Apache Spark en CentOS 7. Gracias por usar este tutorial para instalar Apache Spark en sistemas CentOS 7. Para obtener ayuda adicional o información útil, le recomendamos que consulte el sitio web oficial de Apache. Sitio web de Spark.