Mi comando mágico en tal situación es:

du -m . --max-depth=1 | sort -nr | head -20

Para usar esto:

cden el directorio de nivel superior que contiene los archivos que consumen espacio. Esto puede ser/si no tienes idea;-)- ejecutar

du -m . --max-depth=1 | sort -nr | head -20. Esto enumerará los 20 subdirectorios más grandes del directorio actual, ordenados por tamaño decreciente. cden el directorio más grande y repite eldu ...comando hasta que encuentre los archivos GRANDES

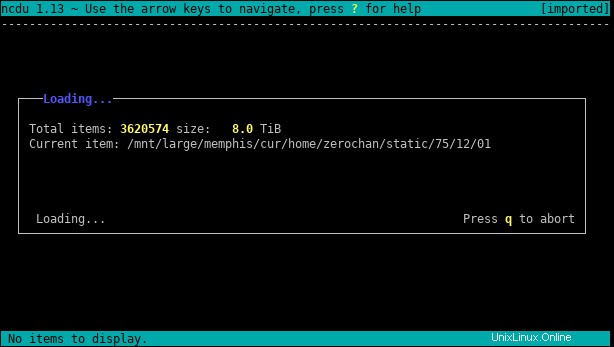

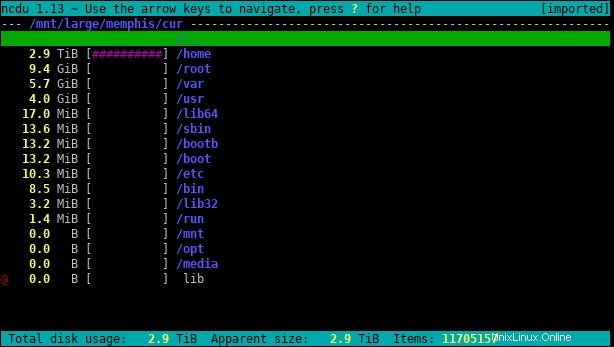

ncdu es una gran herramienta para este tipo de problema. Aquí está el paquete correspondiente.

Puedes usar -x si desea permanecer en un solo sistema de archivos, sin seguir los enlaces simbólicos. Por ejemplo, como root:

ncdu -x /home

Es el equivalente en línea de comandos de DaisyDisk, Baobab o WinDirStat.

Puede llevar mucho tiempo escanear carpetas grandes, pero una vez hecho, debería ser muy rápido encontrar los archivos más grandes.

Si tiene una idea del tamaño real del archivo, puede find archivos más grandes que un tamaño específico.

Por ejemplo, para buscar archivos de más de 10 MiB:

find /mounted/drive -size +10M

O

find /mounted/drive -size +10M -exec ls -lh {} +

La sugerencia de Httqm también es buena si el problema no es un archivo grande sino una gran colección de archivos más pequeños. Eso es usar du para mostrar los totales del directorio. Limitando con --max-depth es muy útil con grandes árboles de directorios:

du -m some/directory --max-depth=1 | sort -nr | head -20

du some/directory --max-depth=1 | sort -n | tail -21

Dividirá un solo directorio en subdirectorios, el segundo de estos también le dará el total del directorio que está enumerando.