Hadoop es un marco de código abierto que se usa ampliamente para manejar Bigdata . La mayoría de los Bigdata/Análisis de datos los proyectos se están construyendo sobre el Ecosistema Hadoop . Consta de dos capas, una es para almacenamiento de datos y otro es para Procesamiento de datos .

Almacenamiento será atendido por su propio sistema de archivos llamado HDFS (Sistema de archivos distribuido Hadoop ) y Procesamiento será atendido por YARN (Otro negociador de recursos más ). Mapreducir es el motor de procesamiento predeterminado del ecosistema Hadoop .

Este artículo describe el proceso para instalar el pseudonodo instalación de Hadoop , donde todos los demonios (JVM ) ejecutará nodo único Clúster en CentOS 7 .

Esto es principalmente para que los principiantes aprendan Hadoop. En tiempo real, Hadoop se instalará como un clúster multinodo donde los datos se distribuirán entre los servidores como bloques y el trabajo se ejecutará de manera paralela.

Requisitos

- Una instalación mínima del servidor CentOS 7.

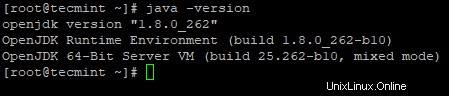

- Lanzamiento de Java v1.8.

- Lanzamiento estable de Hadoop 2.x.

En esta página

- Cómo instalar Java en CentOS 7

- Configurar inicio de sesión sin contraseña en CentOS 7

- Cómo instalar Hadoop Single Node en CentOS 7

- Cómo configurar Hadoop en CentOS 7

- Formateo del sistema de archivos HDFS a través de NameNode

Instalación de Java en CentOS 7

# yum install java-1.8.0-openjdk

# java -version

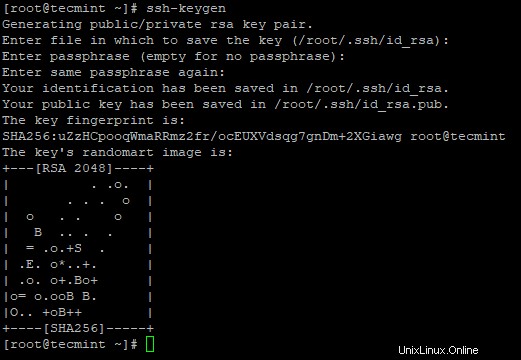

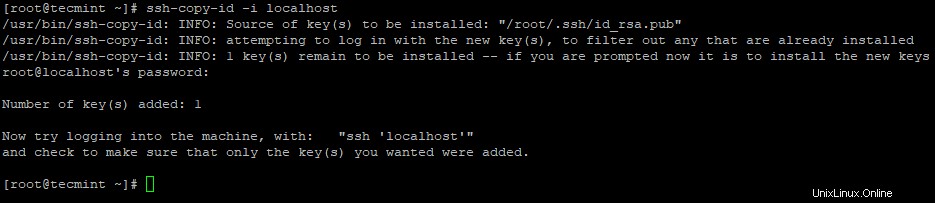

Configurar inicio de sesión sin contraseña en CentOS 7

Necesitamos tener ssh configurado en nuestra máquina, Hadoop administrará los nodos con el uso de SSH . El nodo maestro usa SSH conexión para conectar sus nodos esclavos y realizar operaciones como iniciar y detener.

Necesitamos configurar ssh sin contraseña para que el maestro pueda comunicarse con los esclavos usando ssh sin contraseña. De lo contrario, para cada establecimiento de conexión, debe ingresar la contraseña.

# ssh-keygen # ssh-copy-id -i localhost

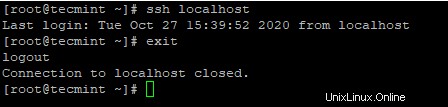

# ssh localhost

Instalación de Hadoop en CentOS 7

# wget https://archive.apache.org/dist/hadoop/core/hadoop-2.10.1/hadoop-2.10.1.tar.gz # tar xvpzf hadoop-2.10.1.tar.gz

~/.bashrc archivo como se muestra.

HADOOP_PREFIX=/root/hadoop-2.10.1 PATH=$PATH:$HADOOP_PREFIX/bin export PATH JAVA_HOME HADOOP_PREFIX

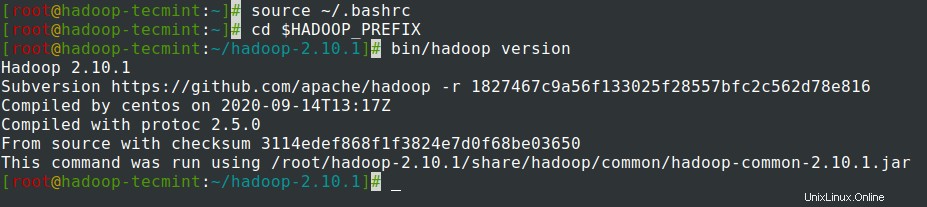

~/.bashrc el archivo, obtenga el archivo y verifique Hadoop ejecutando los siguientes comandos.

# source ~/.bashrc # cd $HADOOP_PREFIX # bin/hadoop version

Configuración de Hadoop en CentOS 7

Necesitamos configurar los archivos de configuración de Hadoop a continuación para que se ajusten a su máquina. En Hadoop, cada servicio tiene su propio número de puerto y su propio directorio para almacenar los datos.

- Archivos de configuración de Hadoop:core-site.xml, hdfs-site.xml, mapred-site.xml y yarn-site.xml

JAVA_HOME y Hadoop ruta en hadoop-env.sh archivo como se muestra.

# cd $HADOOP_PREFIX/etc/hadoop # vi hadoop-env.sh

Introduzca la siguiente línea al principio del archivo.

export JAVA_HOME=/usr/lib/jvm/java-1.8.0/jre export HADOOP_PREFIX=/root/hadoop-2.10.1

core-site.xml archivo.

# cd $HADOOP_PREFIX/etc/hadoop # vi core-site.xml

Pegar lo siguiente entre <configuration> etiquetas como se muestra.

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

tecmint directorio de inicio del usuario, que se utilizará para NN y DN almacenamiento.

# mkdir -p /home/tecmint/hdata/ # mkdir -p /home/tecmint/hdata/data # mkdir -p /home/tecmint/hdata/name

hdfs-site.xml archivo.

# cd $HADOOP_PREFIX/etc/hadoop # vi hdfs-site.xml

Pegar lo siguiente entre <configuration> etiquetas como se muestra.

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/tecmint/hdata/name</value>

</property>

<property>

<name>dfs .datanode.data.dir</name>

<value>home/tecmint/hdata/data</value>

</property>

</configuration>

mapred-site.xml archivo.

# cd $HADOOP_PREFIX/etc/hadoop # cp mapred-site.xml.template mapred-site.xml # vi mapred-site.xml

Pegar lo siguiente entre <configuration> etiquetas como se muestra.

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

yarn-site.xml archivo.

# cd $HADOOP_PREFIX/etc/hadoop # vi yarn-site.xml

Pegar lo siguiente entre <configuration> etiquetas como se muestra.

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

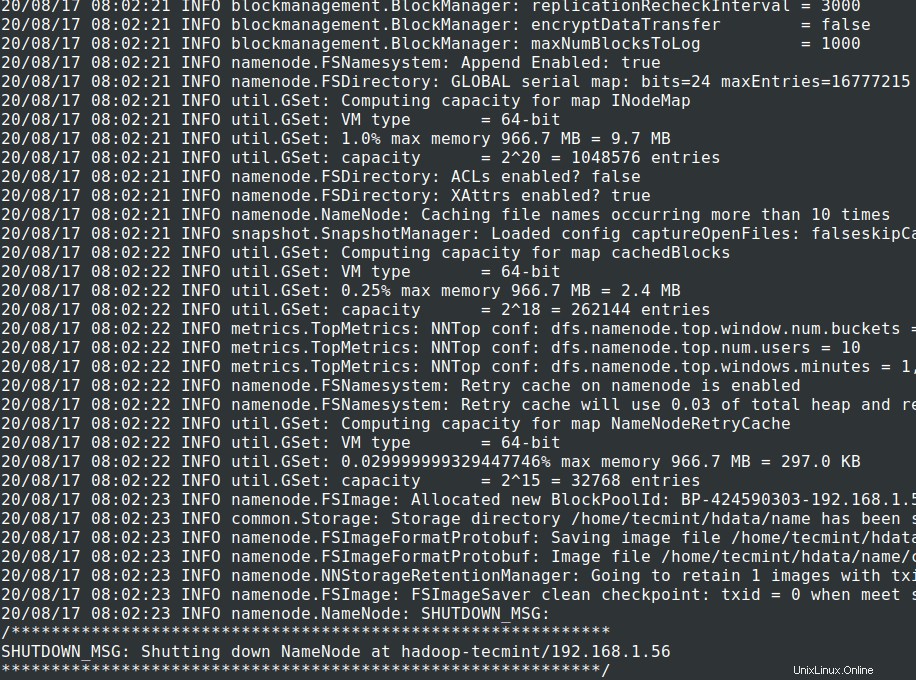

Formateo del sistema de archivos HDFS a través de NameNode

Formateando el NN provocará la pérdida de datos en el metastore de NN, por lo que debemos ser más cautelosos, no debemos formatear NN mientras el clúster se está ejecutando, a menos que se requiera intencionalmente.

# cd $HADOOP_PREFIX # bin/hadoop namenode -format

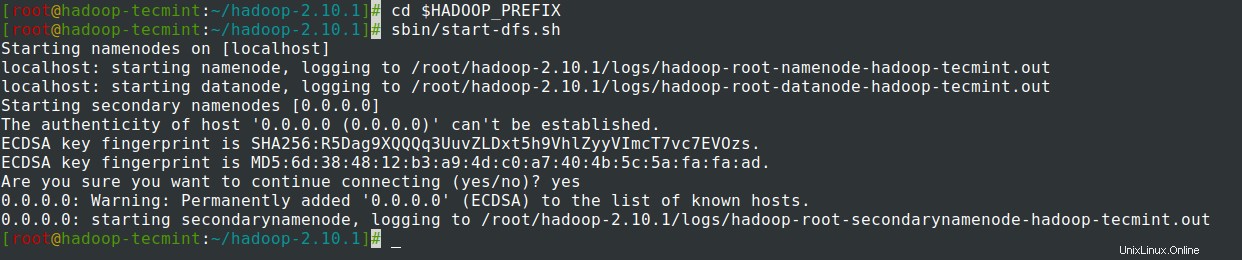

# cd $HADOOP_PREFIX # sbin/start-dfs.sh

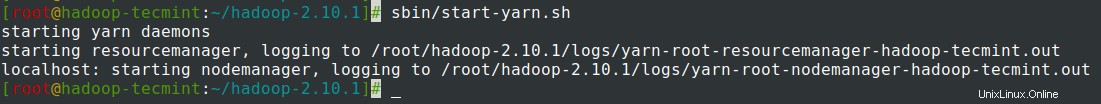

# sbin/start-yarn.sh

# sbin/stop-dfs.sh # sbin/stop-dfs.sh

Resumen

Resumen

En este artículo, hemos repasado el proceso paso a paso para configurar Pseudonode Hadoop (Nodo único ) Clúster . Si tiene conocimientos básicos de Linux y sigue estos pasos, el clúster se activará en 40 minutos.

Esto puede ser muy útil para que el principiante comience a aprender y practicar Hadoop o esta versión vainilla de Hadoop se puede utilizar para fines de desarrollo. Si queremos tener un clúster en tiempo real, necesitamos al menos 3 servidores físicos disponibles o tenemos que aprovisionar la nube para tener varios servidores.